abin 发表于 2022-10-13 18:10

hpc4you toolkit solo

适用于不想自己动手的朋友.

wxyhgk 发表于 2022-10-13 18:58

看了下你这个后续的要钱

abin 发表于 2022-10-13 19:07

要么自己花时间,

要么花钱, 就这么简单.

wxyhgk 发表于 2022-10-13 19:12

半个小时可以搞定的事情得花几百,个人感觉你这个比较坑了

sun35mr 发表于 2022-11-8 00:34

想请教一下楼主,关于 SchedulerType=sched/backfill,这里用 backfill 好还是 buildin 好呢?

sun35mr 发表于 2022-11-8 00:34

想请教一下楼主,关于 SchedulerType=sched/backfill,这里用 backfill 好还是 buildin 好呢?

阿司匹林泡腾片 发表于 2022-11-8 15:16

这个邮件提醒很nice,感谢楼主

paramecium86 发表于 2022-11-9 17:11

感谢楼主教程。您好请问这种设置下如果想要slurm同时跑几个任务该怎么设置。我看了下现在这样一次运行一个 ...

shenzekai 发表于 2022-11-9 19:20

楼主好,可以问一下在输入sinfo之后出现下面这种报错应该如何解决呢?

paramecium86 发表于 2022-11-10 19:52

您好。我看着这个链接依然没有找到如何让单一node同时队列里运行多个任务的方法。都是提交上去一个在run ...

paramecium86 发表于 2022-11-10 19:52

您好。我看着这个链接依然没有找到如何让单一node同时队列里运行多个任务的方法。都是提交上去一个在run ...

wxyhgk 发表于 2022-11-10 23:04

举 g16 来说,我自己写一个配置吧

上面的计算节点中的 Ubuntu-5950x 修改成你的计算节点

paramecium86 发表于 2022-11-11 09:46

谢谢您的回复。我用了这种写法,不过是我没形容好问题。这样写脚本,这样两个任务还是排在同一个slurm的j ...

biogon 发表于 2022-11-11 09:57

发你的slurm.conf上来看看,还有你这个任务用了多少核

paramecium86 发表于 2022-11-11 09:46

谢谢您的回复。我用了这种写法,不过是我没形容好问题。这样写脚本,这样两个任务还是排在同一个slurm的j ...

paramecium86 发表于 2022-11-11 10:10

谢谢您,这是我的 slurm.conf 这几个任务我就是测试用,脚本里设置是调用2个核心。

wxyhgk 发表于 2022-11-11 16:32

我查过了似乎是不行的这样的,slrum 一个节点只能运行一个脚本

biogon 发表于 2022-11-11 22:30

不要注释掉SelectTypeParameters=CR_Core

mxh 发表于 2022-11-16 16:00

老师,您好。使用测试命令:echo "邮件内容" | s-nail -s "邮件主题" 你的qq邮箱地址,我可以收到qq邮箱的 ...

wxyhgk 发表于 2022-11-17 00:33

不应该啊,你是不是提交错了还是什么?使用

看看是不是在运行

mxh 发表于 2022-11-17 09:37

老师,运行成功了,我之前一直用slurm,看到您的配置邮件的帖子,觉得非常有用进行了尝试,但没有收到邮 ...

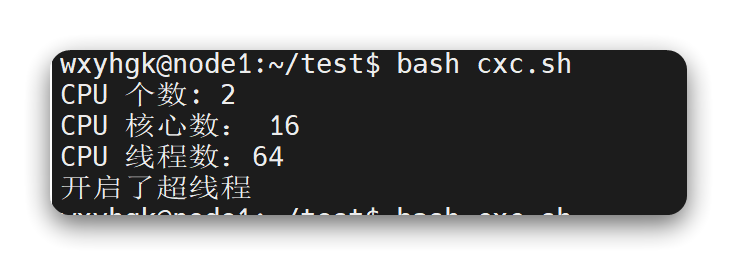

编写以下脚本:

#!/bin/bash

cpuhx=`cat /proc/cpuinfo | grep "cores" | uniq | awk -F":" '{print $2}'`

echo "CPU 核心数:$cpuhx" ;

cpuxc=`cat /proc/cpuinfo | grep "processor" | wc -l`

echo "CPU 线程数:$cpuxc" ;

echo "如果线程数是核心数的两倍,为开启了超线程"

复制代码

然后使用命令 bash cxc.sh 运行脚本,看看线程数是不是核心数的两倍,如果是就开启了,没有就没开启。

乐平 发表于 2022-11-20 17:13

楼主您好!

关于脚本里的线程数与 CPU 核心数有个疑问。由于是双路 CPU(我的塔式服务器有两个 CPU ...

Reminder 发表于 2022-11-20 23:21

楼主您好,请问输入sinfo后出现如下报错应如何解决?

wxyhgk 发表于 2022-11-20 20:20

这个脚本我博客里面更新了,之前的 bash 水平不高,写了个临时的,可以使用新脚本

wxyhgk 发表于 2022-11-20 20:20

这个脚本我博客里面更新了,之前的 bash 水平不高,写了个临时的,可以使用新脚本

myzpku 发表于 2022-11-21 17:08

请问楼主:当如图中线程数是CPU核数4倍时ThreadsPerCore还是写2么?

wxyhgk 发表于 2022-11-9 18:39

到这里自己配置 https://docs.hpc.sjtu.edu.cn/job/slurm.html

乐平 发表于 2023-4-24 14:36

Ubuntu 22.04 系统按照您的方法用

安装后可以显示 slurmd 的版本号

wxyhgk 发表于 2023-4-24 15:00

仔细检查配置文件是否有问题,Ubuntu 22.04 我也测试过,应该没问题才对

乐平 发表于 2023-4-24 17:28

谢谢回复。

Ubuntu 22.04 系统里 slurm 配置文件的路径和您的帖子不一样,没有 /etc/slurm-llnl 这个 ...

teikouni 发表于 2023-4-26 16:25

您好,请问安装完之后提交任务发现计算一直没进行,运行时间一直是0,然后取消任务后状态一直处于CG状态是 ...

wxyhgk 发表于 2023-4-26 16:58

我不清楚你做的什么任务,但是可以给你解释 CG 和 PD 的含义

CG (Completing):这表示作业正在完成阶 ...

teikouni 发表于 2023-4-26 21:12

试着运行了一下您教程中的这个任务,然后还是出现了类似的问题,似乎是运行不了,然后一直处于CG状态也结 ...

mxh 发表于 2023-3-30 09:08

请问各位老师,我们用的超算squeue可以显示所用的CPUs,我照这个教程在组内服务器安装slurm,可以运行,如 ...

乐平 发表于 2023-5-9 22:49

安装完之后启动 slurm

llity 发表于 2023-5-15 13:24

谢谢分享,发现邮件通知功能出错。Ubuntu server 22.04

wxyhgk 发表于 2023-5-15 20:03

你前面做了测试了吗,给出你的 g09.slurm 代码

llity 发表于 2023-5-22 14:13

重新安装一遍可以了,谢谢。一个疑问:

安装slurm和slurm-wlm slurm-wlm-doc有什么区别,谢谢

乐平 发表于 2023-5-22 21:33

顾名思义,doc 应该是文档

llity 发表于 2023-5-22 23:27

这个是的,还有一个slurm安装包,没有wlm后缀

Download Slurm

Slurm source can be downloaded from https://www.schedmd.com/downloads.php.

Slurm has also been packaged for Debian and Ubuntu (named slurm-wlm), Fedora, and NetBSD (in pkgsrc) and FreeBSD.

wxyhgk 发表于 2022-10-13 19:12

半个小时可以搞定的事情得花几百,个人感觉你这个比较坑了

paramecium86 发表于 2022-11-11 09:46

谢谢您的回复。我用了这种写法,不过是我没形容好问题。这样写脚本,这样两个任务还是排在同一个slurm的j ...

QingquanMa 发表于 2024-6-1 01:11

vasp 能用吗

wxyhgk 发表于 2022-11-9 18:39

到这里自己配置 https://docs.hpc.sjtu.edu.cn/job/slurm.html

lurensan 发表于 2024-7-11 01:22

感谢大佬的教程,请问关于一次只能跑一个任务的问题怎样解决呢?上面的网址看过了,仍然没有头绪

wxyhgk 发表于 2024-7-11 08:34

这个需要改成 mix 模式才会比较好,晚点我更新下

lurensan 发表于 2024-7-11 09:08

好的,期待大佬的操作

| 欢迎光临 计算化学公社 (http://bbs.keinsci.com/) | Powered by Discuz! X3.3 |