计算化学公社

标题: 改进V100速度直逼H100!论软硬件全栈调优对科学计算的意义 [打印本页]

作者Author: Entropy.S.I 时间: 2025-12-14 22:48

标题: 改进V100速度直逼H100!论软硬件全栈调优对科学计算的意义

本帖最后由 Entropy.S.I 于 2025-12-14 22:49 编辑

改进V100速度直逼H100!论软硬件全栈调优对科学计算的意义

——Switch to SAI(第一集)

Dec-2025 by ENTROPY-YU

如今人们普遍迷信最新的顶级GPU,认为只有它们才能代表极致的性能。然而,对于计算化学、计算物理和计算材料学等科学计算领域,这一逻辑已被打破。

笔者对2025年9月上线的SAI开源超级计算机开展了广泛的性能测试,结果显示,经过软硬件全栈调优的“改进型V100”在科学计算的核心场景下,性能表现令人惊叹——不仅轻松碾压传统CPU和传统V100,更直逼H100这一皇冠上的明珠,而成本却仅有H100的零头。

1 测试方法

1.1 测试平台列表

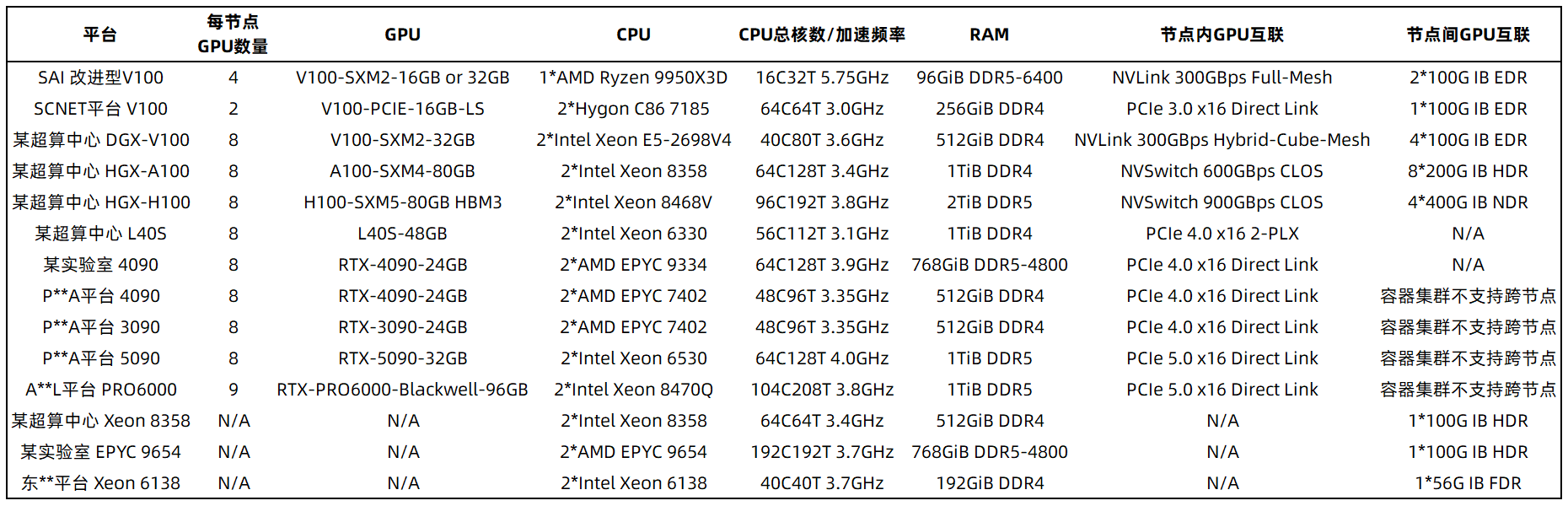

笔者尽可能选取了市场上容易获得的、典型的硬件配置进行横向测试。以下是所有参与测试的硬件平台配置(部分平台名称已隐藏,且DCU未列出):

1.2 测试用例简介

本文包含7个科学计算测试用例。

- ABACUS LCAO基组结构优化:116原子Fe5C2(510)表面体系,CPU采用genelpa求解器, GPU采用cusolver求解器,采用APNS赝势轨道库的赝势和效率轨道,SCF收敛限1e-7,高斯展宽,sigma取0.004 Ry,真空层在Y轴方向,K点取3-1-2,在Y轴方向加入偶极校正,结构优化方法为bfgs_trad,结构优化收敛限为0.03 eV/Ang,mixing_ndim = 20。

- VASP Gamma-only单离子步计算:480原子CoMn-PBA体系,非自旋极化(ISPIN=1),标准精度(ENCUT=400 eV),采用GGA-PBE泛函,电子步采用RMM-DIIS算法(IALGO=48)配合实空间投影(LREAL=Auto),并开启ADDGRID以增加积分格点密度。仅执行单步NVT动力学模拟且关闭了主要I/O输出。

- VASP HSE+SOC单点计算:UKHPC ARCHER的官方benchmark,可从GitHub获取:https://github.com/hpc-uk/archer ... rs/VASP/CdTe_Hybrid

- 中小体系DPMD模拟:8,192原子Sc-Ga-N超胞,DP模型使用TensorFlow后端在DP_INTERFACE_PREC=low设置下训练(以确保尽可能使用FP32精度),描述符为se_e2_a,包含3种元素,启用了type_one_side,并在训练完成后进行了compress。

- DPA-1模型训练:2023年发表的钙钛矿氧化物通用力场UniPero(DOI: 10.1103/PhysRevB.108.L180104),所有输入文件可从GitHub获取:https://github.com/sliutheorygroup/UniPero ,采用FP64精度,TensorFlow后端。

- NEP MD模拟:84,000原子TMCM-TMFM分子铁电材料体系,由于涉及尚未发表的研究,cutoff等详细参数暂时保密。

- 较大体系DPMD模拟:256,000原子Sc-Al-N狭长超胞(约6.4*5.5*80 nm^3),DP模型使用TensorFlow后端在DP_INTERFACE_PREC=low设置下训练(以确保尽可能使用FP32精度),描述符为se_e2_a,包含5种元素,启用了type_one_side,并在训练完成后进行了compress。

1.3 编译和环境简介

除DeePMD-kit使用官方offline package外,全部采用本地编译,启用针对目标GPU的优化。SAI上所有软件均为系统预置,开箱即用状态。ABACUS采用toolchain;VASP GPU版采用NVHPC(其中在SAI上为深度优化版),CPU版均使用MKL;GPUMD启用USE_TABLE。由于涉及的不同平台环境差异巨大,环境依赖方面无法严格控制变量,但测试严格遵循“默认开箱即用,否则特别注明”原则,且这种环境差异本就是难以改变的现实,同时也是“性能调优”的重要环节,有必要耦合在测试中。

2 结果与讨论

2.1 速度全面抵近H100,性价比全面领先4090

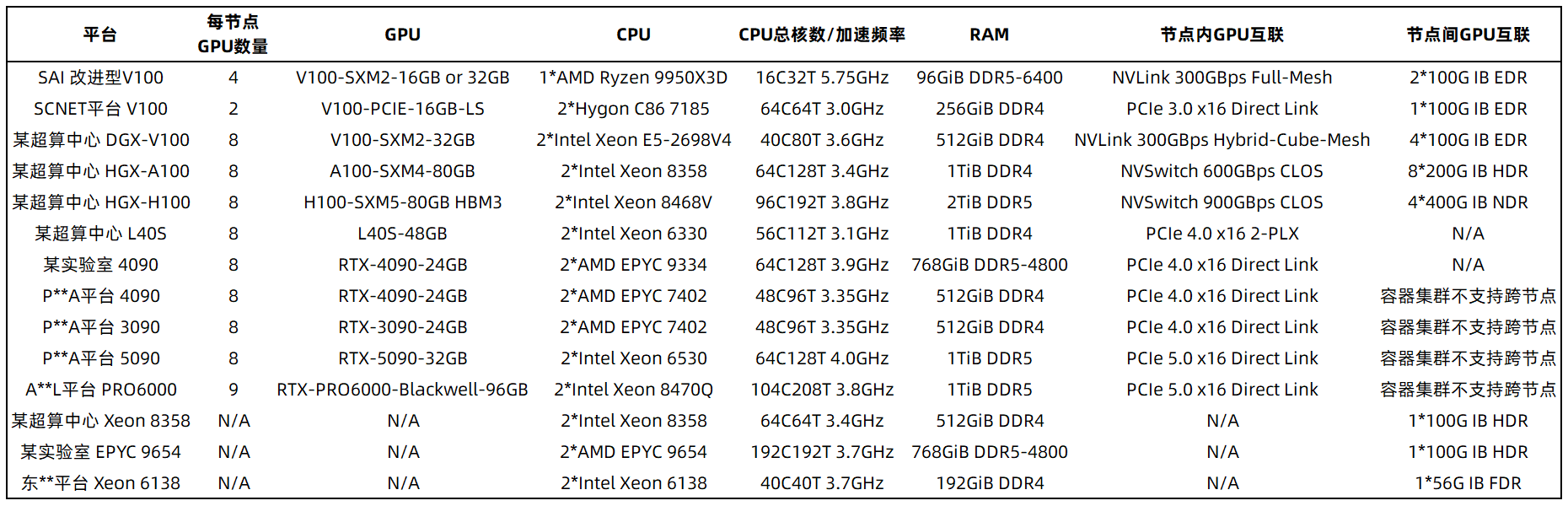

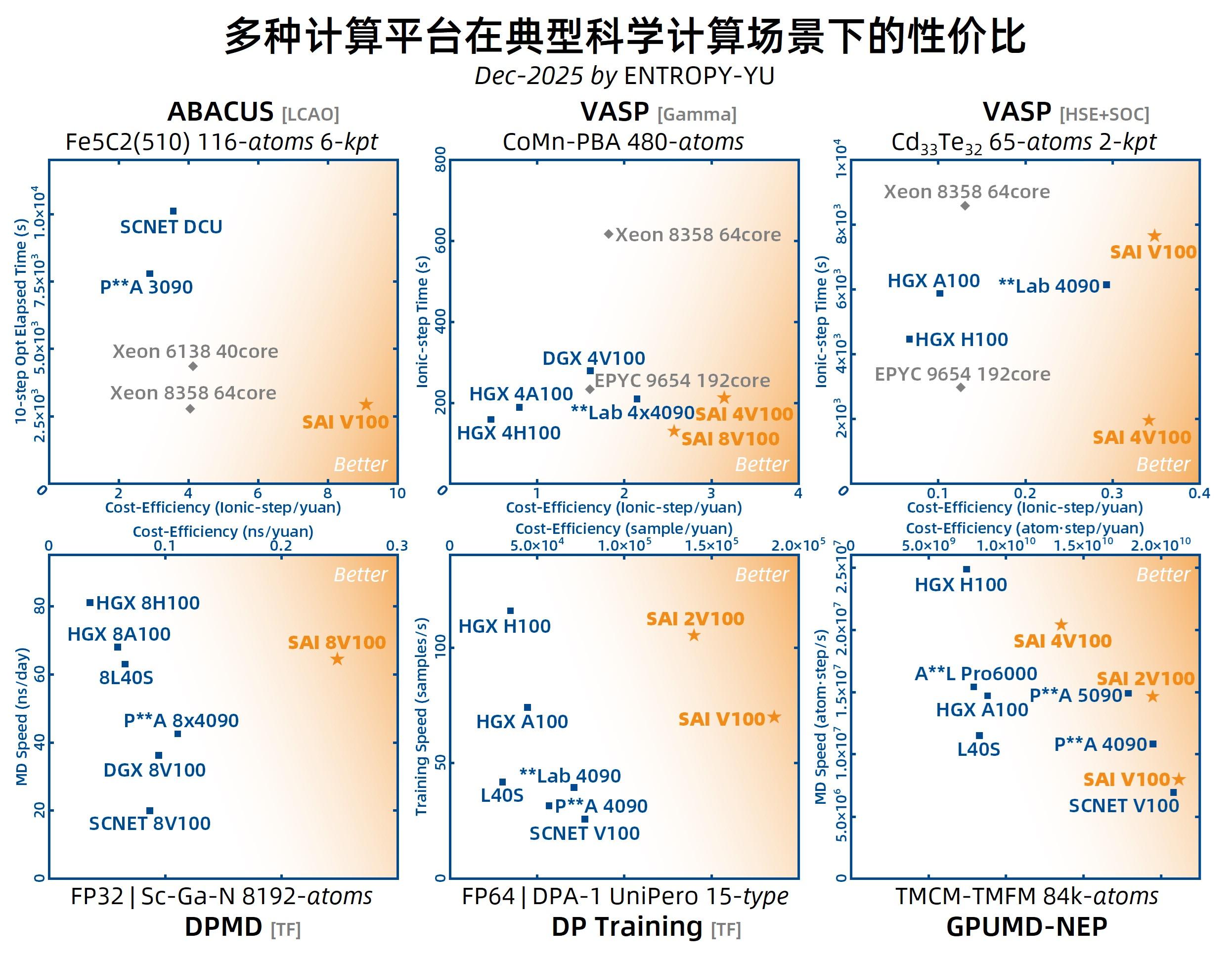

对多种典型科学计算应用场景进行测试,并使用2025 Q4市场典型价格评估性价比。

其中:SAI V100在使用16G的情况下取1.35元/卡时,使用32G的情况下取1.44元/卡时;其他平台V100根据实际情况取1.2、2.0、5.0元/卡时不等;3090取1.6元/卡时;4090取2元/卡时;5090取3元/卡时;PRO6000取7元/卡时;L40S取5元/卡时;A100取6元/卡时;H100取12元/卡时;CPU统一取0.05元/核时。

- 对于ABACUS LCAO基组结构优化计算,使用单卡改进型V100即可达到主流双路CPU服务器的速度,与主流超算平台上相同价位的GPU/DCU相比领先3~4倍。

- 对于VASP Gamma-only计算,使用4卡改进型V100即可超越顶级CPU服务器的速度,达到主流CPU服务器的3倍,与4卡HGX-A100持平,逼近4卡HGX-H100。进一步采用8卡并行,则可超越4卡HGX-H100。

- 对于VASP HSE+SOC计算,单卡改进型V100即可超越主流CPU服务器、逼近A100和4090,通过4卡并行即可大幅领先于顶级CPU服务器,达到H100的2倍以上。

- 对于典型的中小体系DPMD模拟, 8卡改进型V100性能可达到主流8卡V100的2~3倍,显著强于主流超算平台的8卡4090,与8卡HGX-A100基本持平,直逼8卡HGX-H100。

- 对于典型的DPA-1模型训练,单卡改进型V100性能可达到主流V100的2倍,与HGX-A100基本持平,显著强于L40S等双精度算力较弱的GPU。

- 对于NEP MD模拟,单卡改进型V100性能虽不及4090,但通过2卡并行可轻松跨过4090、追平5090,同时仍有领先的性价比。

综上所述,在典型科学计算任务中,改进型V100性能显著高于主流V100,领先幅度高达20~200%,与HGX-A100、L40S、RTX PRO 6000 Blackwell、RTX 4090、RTX 5090等较新的高端GPU不相上下,基本可达到HGX-H100的一半水平。在此基础上,SAI的性价比显著领先,高于所有其他平台,达到多数平台的2倍以上。对于在相同GPU数量下落后的任务,SAI可通过高效多卡并行追平HGX-H100等顶级GPU,同时依然具有显著领先的性价比。

值得注意的是,许多基于容器集群的平台采用了“开机即计费”模式,这种模式在用户实际使用中会产生严重浪费,因此其实际性价比在图中同型GPU的基础上还要进一步打折扣。

2.2 超越H100

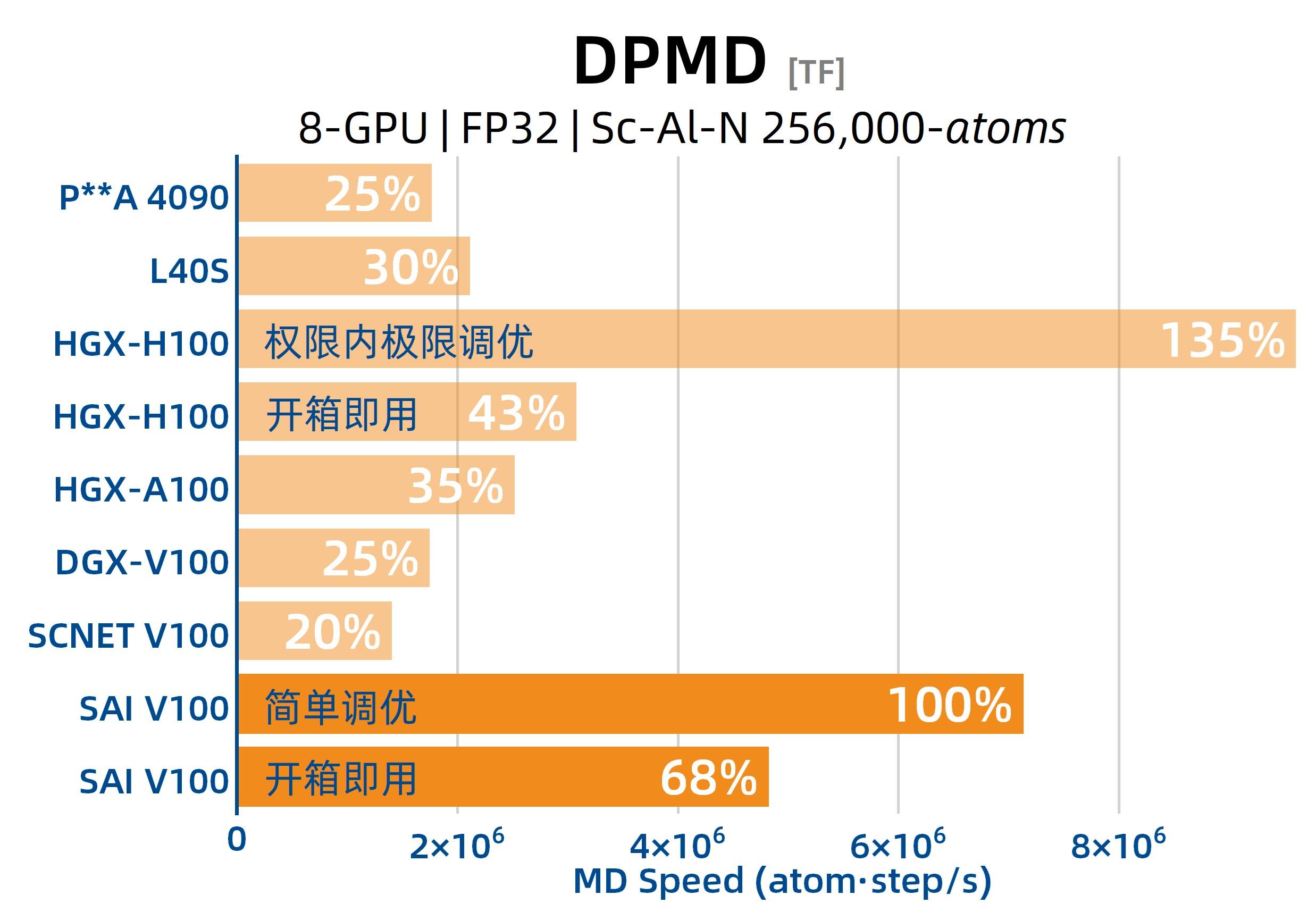

上一节未涉及较大体系,因此我们额外测试一个相对典型的大体系DPMD分子动力学模拟,注意:此案例中在所有硬件平台上公平地使用8块GPU运行测试。

其中:对SAI分别测试了 使用系统预置sbatch模板开箱即用 和 根据用户手册调优1项sbatch参数 的速度;对HGX-H100分别测试了 使用普通sbatch写法开箱即用 和 根据笔者在SAI上经验进行权限内最极限调优 的速度;对其他硬件平台则均使用普通sbatch写法开箱即用地运行。

结果显示:在开箱即用状态下,8卡改进型V100的性能达到了主流8卡V100的3倍左右,达到了HGX-H100的近2倍,而只需经过简单调优,即可达到普通V100的4~5倍、HGX-H100的2.5倍,非常令人震惊!

值得注意的是,在HGX-H100上,即使竭尽全力地进行调优,最终仅比在SAI上简易调优快35%,因此我们可以认为改进型V100在此典型科学计算任务中超越H100。

2.3 发生什么事了?

我们需要先从大市场环境开始说起。

当前市场上,以大语言模型(LLM)为导向设计的最新款GPU以及硬件集成商和云服务商所提供的整机、集群和云端算力平台并不适合科学计算。

首先,科学计算对数值精度要求很高,需要双精度(FP64)和单精度(FP32)数据格式,且科学计算程序的算法复杂度远高于LLM,非矩阵乘法的算法占比很大,因此难以利用Tensor Core提供的矩阵乘加速。然而,近两代GPU致力于提升基于Tensor Core的低精度算力,而FP64和FP32非Tensor Core算力相较于前几代的提升幅度不大,无法匹配价格涨幅,整体性价比也无法与新一代CPU抗衡。更令人震惊的是,最新的B300和RTX Pro 6000 Blackwell,以及国内市场流行的RTX 4090和RTX 5090,其FP64算力只能勉强追平12年前的Kepler架构GPU。

其次,科学计算算法往往存在大量的内禀串行逻辑,即使支持GPU加速,串行逻辑往往也需要通过CPU处理,这导致科学计算应用的GPU加速性能往往受限于CPU处理的延迟,进一步依赖CPU单核性能。然而,当前市场上的GPU计算设备往往不关注CPU单核性能,只关注整机在极端高负载场景下的峰值计算吞吐量,这与科学计算的现实应用场景有明显偏差。

此外,科学计算的并行通信模式以高频率的小数据包为主,这高度依赖于处理器之间以及不同计算节点的处理器之间的互联延迟。然而,当前市场上提供的计算集群并未关注互联延迟——其中一部分仅仅追求在大数据包负载下的峰值互联带宽或纸面带宽,并未设计超低延迟组网拓扑和采用超低延迟InfiniBand网络,另一部分则彻底放弃了互联性能。

当前市场上提供的云端GPU算力平台,绝大多数都是容器等虚拟化环境,调度开销大,不符合科学计算场景下普遍的大批量提交计算任务的需求,缺乏弹性,把大量闲置成本转嫁给了消费者。少数提供了Slurm调度的超算平台,也未对GPU和CPU的联合调度进行优化,缺乏CPU与GPU的自动绑定机制以及基于拓扑感知的自动映射调度,导致调度效率和计算效率双低。

基于此现状,SAI的缔造者自主设计了UltraPOD-1344和SlimPOD-144两型“超节点”GPU集群,采用先进的计算组网(Fabric)架构,优选改良了核心硬件,深度优化了BIOS设置、OS内核硬件驱动设置、并行计算通信库与任务调度策略,同时针对具体场景编写了性能调优教程和模板,软硬件全栈联合,实现对有限硬件资源的极致压榨,显著提高了计算效率和资源利用率,唤醒了“沉睡的算力”。

回过头来我们不难发现,从最初的硬件配置表开始,SAI就透露着奇妙:CPU采用了单核性能SOTA水平的9950X3D,内存采用了时序延迟优化到极致的配置,节点内GPU互联采用了“零交换”的Full-Mesh拓扑,节点间Fabric采用了IB-EDR这一历史上延迟最低的InfiniBand协议……在本文没有来得及展示的方面,埋藏着更多软硬件联合优化的艺术。

3 结语

SAI通过全栈优化,使数据集生产、模型训练、大规模推理、跨尺度MD模拟等AI for Science工作流中多种任务负载的速度与性价比提升到了全新境界。

正如《SAI的故事》所言,这是“科学计算基础设施被LLM夺舍之后,科研人员的屯粮过冬运动”。我们不需要为LLM的溢价买单。SAI通过全栈调优,证明了:在科学计算领域,极致的优化可以跨越硬件的代差。

在科学计算的重要意义被重新发现之前的寒冬,为被AI革命暂时遗弃的自然科学研究者提供最合胃口的粮食和最实惠的燃料——这便是SAI的使命。

作者Author: waitingseven 时间: 2025-12-15 12:32

这个是只卖超算机时吗?有卖单个的服务器吗?

作者Author: Entropy.S.I 时间: 2025-12-15 19:38

文档中已经把这笔帐算得很明白,租用SAI的性价比远高于自建,如果买单机,弹性会更低,维护成本比例会更高:https://vcnn7siwx4yx.feishu.cn/wiki/UMpowUQHaiB1mlkA0WacvFiqnK3

作者Author: waitingseven 时间: 2025-12-16 10:16

其实有时候性价比不是最重要的,尤其是租和买差距没有那么大的时候,有的单位就是要看到实物,看到钱花哪儿了。如果单机开箱即用,似乎也不用维护吧,我们采购的塔式服务器用了七年了,至今也没有任何维护,也没出任何问题。我问这个问题只是提个建议,既然这个产品这么好,我更希望它能惠及更多做计算的人,租机时和买单机有可能本来就是互相“排斥”的两拨人,能租也能卖显然受众更广一些,这仅仅是我个人的建议。

作者Author: gaozx 时间: 2025-12-16 11:01

市面上有卖和他一样配置的

作者Author: Entropy.S.I 时间: 2025-12-16 11:09

本帖最后由 Entropy.S.I 于 2025-12-16 12:16 编辑

SAI对单机和超算的架构具有知识产权,包括机内互联板卡设计。如果确有完全雷同的配置,属于侵权。即使硬件配置完全一样,软件和固件层面调优的方法也不见得有其他人能完全学会。

作者Author: Entropy.S.I 时间: 2025-12-16 11:45

本帖最后由 Entropy.S.I 于 2025-12-16 12:06 编辑

本地部署当然支持,但有固定的门槛,用户手册“卫星集群和姊妹集群”章节(卫星集群和姊妹集群 - SAI知识库)写得很明确。如果只是部署单机,那么乙方无法提供任何软件和技术层面的质保与服务,不对性能做任何保证,并且如果要求提供整机硬件的三年金牌质保,那么价格可能会比想象的高得多

至于所谓“维护”,多卡GPU服务器的使用和维护难度可能超过你的想象,如果没有专门的管理员,先不提可能发生的难以排查的隐藏故障,单就使用效率方面就远远无法与由GPU超算行业顶级运维人员全天候盯着的SAI相比。软件编译安装,全栈性能调优,调度系统配置,调度策略优化,多用户权限控制,人工动态优化,等等,能在GPU服务器上同时做好这些的,全国都找不到多少人;如果是多节点环境,复杂度又会提升一个等级。

SAI是支持千卡并行的,稳定性非常好,并行效率也超乎绝大多数人的想象,很多在CPU超算上并行效率很差的任务,在SAI上能获得几乎线性的提升,一些常见的任务通过暴力并行,速度提升成千上万乃至十万倍,都是有实测数据支撑的。

作者Author: waitingseven 时间: 2025-12-16 16:09

我站在用户的角度纯探讨一下:如果说所谓的维护门槛极高而且难以排查所谓的隐藏故障,本身就说明不是一个成熟的开箱即用的产品;不要把所谓的技术门槛想象的太高,尤其是并行计算,中国这样的竞争环境,不是因为没有这方面的人才,而是还没有很多人去做这些事,一旦一件事有利可图,且利润可观,会有很多人趋之若鹜,所谓的领先又能维持多久;千卡并行万卡并行有多少应用场景,其中又有多少愿意冒险一试,CPU超算也不是完成不了,反而这么多单机计算的用户被直接排除。

作者Author: Entropy.S.I 时间: 2025-12-17 00:34

本帖最后由 Entropy.S.I 于 2025-12-17 00:41 编辑

1. 英伟达的HGX系统8卡机、NVL72机柜维护难度都超乎想象。尤其是后者,只能英伟达内部的人驻场才能维护。这些GPU服务器的维护难度远超过普通人想象,是行业普遍现状,GPU服务器的开箱即用程度现在是做不到像CPU服务器一样的,否则二手GPU机器不会掉价这么厉害——因为根本没几个人能维护好,玩过一段时间的人都被折腾得要死要活。现在市场上还有专门的GPU服务器维护企业,那帮人给很多大大小小的团队甚至比较大的云厂商维护GPU服务器,赚得盆满钵满。

2. 事实就是这件事利润很低、市场很窄,基本无利可图,前期投入还非常大。这本质上是基础设施建设,买的都是大宗商品,这种事在大模型领域只有巨头才玩得起,而他们实际上在这类项目上是亏损的,要靠其他项目来填补窟窿,现在还诞生了左脚踩右脚升天的金融玩法,你去看财报就知道了。巨头是看不上科学计算这点市场的,这是一个被遗忘的领域,技术难度比LLM高得多,利润又比LLM低得多。我和其他创始人做这件事单纯只是因为有开源情怀,想做点“慈善”,给被时代浪潮彻底遗忘的科学计算圈子谋一点福利。如果你真的认真看过我之前写的东西,你不可能会认为我是一个想赚钱的人,我什么都不做、纯躺平也能活得不错。

3. 科学计算也有scaling law,我已经看到了。我们实验室在做的体系都大到超乎想象,比以前大了很多个数量级,接下来有的项目只能千卡万卡才能跑了。关键是这样的开支,普通实验室有一个青基就能承受,并没有大多数人想象的这么夸张。现在领域内太缺乏想象力,固执的人们墨守成规。还有一些其他的增长点,我就不说了,不然帖子就成招股书了。

4. 单机用户如果硬要自己买,我前面已经说了,能买,但是没有深度技术支持,基本只能当个玩具玩玩,无法形成强大的生产力。

作者Author: slxc920113 时间: 2025-12-20 09:29

9950X3D只有24条可用的PCIE 5.0通道,怎么驱动4张V100的?即使是用超微的sxmv底板,也需要2个PCIE3.0*16的插槽,B650或者B850的主板都是一个x16一个x8的槽。用PLX拆分的话,PCle 5.0 Switch巨贵无比。

作者Author: Entropy.S.I 时间: 2025-12-20 13:37

本帖最后由 Entropy.S.I 于 2025-12-20 13:59 编辑

SXMV早已弃用,硬件效率受限。重新开的板子有自主知识产权,目前不能透露太多(获得身份认可后签NDA即可获得细节,这是“有限开源”),已知市场上不可能出现相同设计的板子。这些硬件调整还需要固件、并行库、调度器等层面的协同优化,并没有想象的容易。

硬件本身的成本也不是用户需要担心的,SAI的定价公开透明,用户只需要关注到SAI的最终性价比是传统V100的2倍以上,高于4090和5090,同时支持千卡高效并行,在弱扩展单任务(例如数亿原子DPMD)中效率几乎线性,在诸如万原子VASP AIMD等强扩展任务中也能获得非常高效的加速。

作者Author: 二分音符 时间: 2026-1-1 13:08

这个领域确实太沉寂了,我知道的MD定制硬件只有Anton。3090到4090让科学计算吃到了一点红利,但也仅限于此了,后面还是得靠科学计算工作者自己开发合适的硬件。

作者Author: DavyHou 时间: 2026-1-6 16:23

我对机器学习程序MACE的测试就发现大内存512 GB CPU的速度明显高于H100 GPU 的速度

作者Author: LittlePupil 时间: 2026-1-6 23:55

好奇为什么测试用例里不见CP2K的身影?是因为有ABACUS了还是别的原因?

作者Author: zhaoxiaopeng 时间: 2026-1-15 21:02

我想问一个小问题,这个v100,16g的显卡计算vasp最大体系会爆内存呀,如果只计算200个原子以内的话,可以正常运行吗

作者Author: ljh123 时间: 2026-1-15 22:24

想请教一下L40 2R/卡时(高校平台),和贵平台的比较性价比哪个高。由于平台不一样,所以单从卡本身性能上来讲的话。

作者Author: JamesBourbon 时间: 2026-1-23 18:59

CP2K的GPU支持很差,没有特别测试的必要。ABACUS的LCAO GPU支持要好很多

作者Author: LittlePupil 时间: 2026-1-23 23:40

谢谢回复,我猜也是这样。

作者Author: Diotima 时间: 2026-2-3 15:26

很有趣的做法,其实当年李东岳卖他的CFD服务器的时候也提出过:一味地堆硬件性能不如拿现有设备做好调优。调优对计算能起到的加成其实很大。可惜俺技术水平不行,还是不大懂这种调优技术应该咋操作。有机会的话也想试试自己练一练调优这个技术。

| 欢迎光临 计算化学公社 (http://bbs.keinsci.com/) |

Powered by Discuz! X3.3 |